2017 年底,国外论坛出现的一个ID 为“deepfakes”的用户发布了通过机器学习来更换视频人脸的人工智能算法,一脚踢开了人工智能换脸大门。不过当时该技术的使用门槛还比较高,需要编译代码等操作。

而一个月后,有人将他公开的的算法加以改造推出简易版人工智能换脸工具“FakeApp”,这次,就算是普通用户,也能够顺利操作。

随着换脸技术的升级及相关应用的开源,换脸用途也从最初的娱乐逐渐演变成犯罪工具,引发了人们越来越多对人工智能换脸的担忧。

首先是对于信息的真实性形成严峻的挑战。PS 发明后,有图不再有真相;而人工智能换脸技术的出现,则让图像也开始变得镜花水月了起来:这对于本来就假消息满天飞的互联网来说,无疑会造成进一步的信任崩坏。

其次,这会大大增加侵犯肖像权的可能,没人愿意自己的脸庞出现在莫名其妙的视频当中,此前就有在某成人视频网站上,某女星的脸被“安”在了成人视频女主角脸上的报道,这将给女星的名誉带来极大的负面影响。

鉴于这项技术所带来的伦理问题和潜在威胁,先进的 DeepFake 检测技术将非常重要。

在以前的研究中,DeepFake 视频检测主要专注于在具备强监督标注的情况下,如何较好地检测到 DeepFake 图像或者人脸。

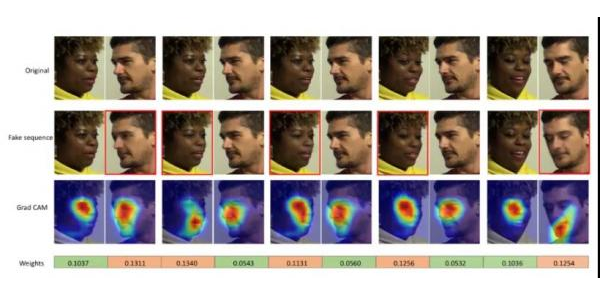

现在,阿里安全图灵实验室和中科院计算所合作完成的一项研究更加关注现实中广泛存在的问题:部分攻击(篡改)的视频,即视频中只有部分人脸被篡改了。

具体来说,该研究提出了基于多实例学习的 DeepFake 检测框架,将人脸和输入视频分别当作多实例学习 (Multiple Instance Learning, MIL) 里的实例和包进行检测。

然而,传统的多实例学习存在梯度消失问题。为此,研究人员提出了 Sharp-MIL (S-MIL),将多个实例的聚合由输出层提前到特征层,一方面使得聚合更加灵活,另一方面也利用伪造检测的目标函数直接指导实例级深度表征的学习,从而缓解传统多实例学习面临的梯度消失难题。该研究通过理论证明了 S-MIL 可以缓解传统 MIL 存在的梯度消失问题。

研究人员表示,除了部分换脸检测任务之外,该研究成果对于一般性的视频多实例学习与标注技术研究也具有重要的启发意义,而人工智能换脸技术及其检测技术也值得我们持续关注。